「機械学習は道具。使いこなせるかは利用者次第」――識者が語る、公平性に配慮した機械学習の要点とは

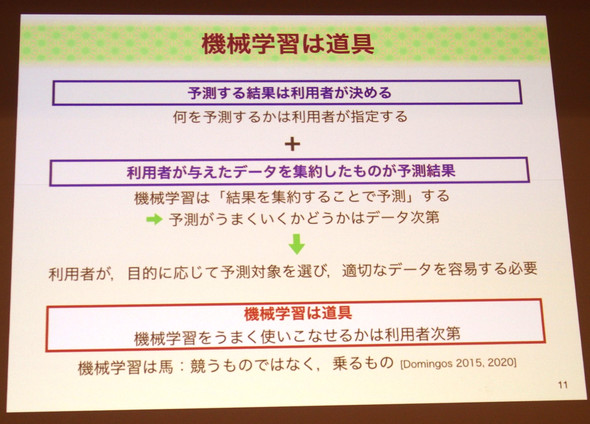

「機械学習は道具であり、うまく使いこなせるかどうかは利用者次第。適切に利用する方法は、利用者が自ら考える必要がある」――産業技術総合研究所の神嶌敏弘氏は、人工知能学会らが1月9日に開いた「機械学習と公平性に関するシンポジウム」に登壇し、こう語った。

機械学習と公平性を巡っては、2019年に米Amazon.comが人材採用で使った機械学習システムが、女性差別を助長するとして運用中止に至る問題が発生。このように、機械学習の不適切な利用が公平性に欠ける結果をもたらす例が、昨今問題視されるようになってきた。

人工知能学会らはこの問題を踏まえ、19年12月に「機械学習の不適切な利用は公平性を欠く可能性がある」などと注意を呼び掛ける声明文を発表していた。注意喚起に向けた取り組みの一環として、今回のシンポジウム開催に至ったという。

公平性に欠ける結果を生まないよう、機械学習を適切に利用していくにはどうすればいいのか。機械学習と公平性について研究している神嶌氏が解説した。

問題が起きたらモデル改善などの対処を

神嶌氏はまず「機械学習は道具である」と強調。「目的に応じて(機械学習の)予測対象を選び、適切なデータを用意する必要がある」と指摘した。

機械学習は文字通りコンピュータが学習を行うことだが、学習用のデータを用意し、何を予測するかを決めるのは人間だ。例えば上記のAmazonの例なら、学習用の履歴書データはAmazonで用意したもの。性別による偏りがあるなら、偏ったデータを用意して学習させた担当者の問題になる――というわけだ。

また神嶌氏は、「(学習用のデータとして)性別や人種などのセンシティブな特徴を利用しないという方法がある」と提言した。ただし、性別や人種などのデータを学習させないよう留意しても、意図せず教師データに一定の傾向が生まれるケースがあるという。

例えば、特定の地域の居住者を対象にしたローン審査の仕組みを、機械学習で構築するとしよう。もし、調査対象のエリアに特定の人種がまとまって住んでいたとしたらどうだろうか。「その場合、住所情報を学習させると、間接的に人種に関する特徴を使って学習させていることになる」と神嶌氏は指摘する。

このように、バイアスが入らないよう注意しても、それを完全に排除することは難しい。そこで神嶌氏は「問題が起きたときに対処できるよう備えることが大事だ」と話す。「コンピュータは人間と違い、容易に大量のデータを取得できる。問題が起きたときに原因を調査することも可能なので、人間が機械学習モデルを修正するなどして問題に対処できる」(神嶌氏)

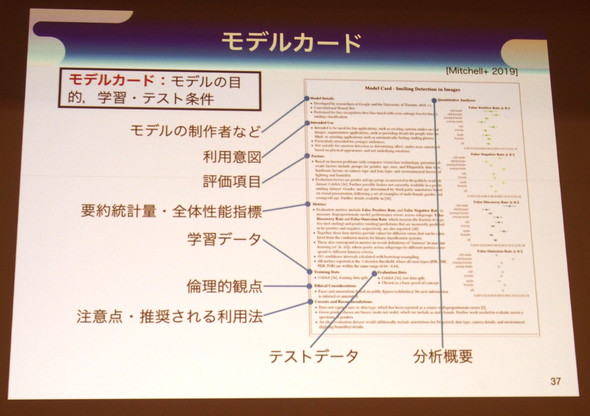

機械学習を利用したシステムを運用する際は、システムの監視とモデルの修正を継続的に行うことが重要という。そのためには、第三者が見ても分かるようにモデル構築に関する情報を残しておく必要がある。実際に、モデルの詳細や利用目的、訓練・評価の方法、注意点などを記載した「モデルカード」というドキュメントを用意する例もあるとしている(関連リンク、英文)。

「機械による予測は不確実な部分があるが、人間であってもそれは同じだ。問題が起きたときにすぐ対処できるよう備えておくことで、公平性は改善できる」(神嶌氏)

Copyright © ITmedia, Inc. All Rights Reserved.

続きを読むには、コメントの利用規約に同意し「アイティメディアID」および「ITmedia NEWS アンカーデスクマガジン」の登録が必要です

関連記事

Special

PR

機械学習の不適切な利用に注意、公平性欠く恐れも 人工知能学会らが注意喚起

機械学習の不適切な利用に注意、公平性欠く恐れも 人工知能学会らが注意喚起 「AIと倫理は経営課題」弁護士が警鐘 「日本企業はもっと真剣に取り組むべき」

「AIと倫理は経営課題」弁護士が警鐘 「日本企業はもっと真剣に取り組むべき」 AIと人の関係、鋭く表現 SFマンガ「AIの遺電子」などが人工知能学会で表彰

AIと人の関係、鋭く表現 SFマンガ「AIの遺電子」などが人工知能学会で表彰 安易にAIを使って大丈夫? AIにまつわる法と倫理と社会課題

安易にAIを使って大丈夫? AIにまつわる法と倫理と社会課題 文系でも分かる「機械学習」のススメ 教師あり/なし、強化学習を解説

文系でも分かる「機械学習」のススメ 教師あり/なし、強化学習を解説